1- L’IA : bien plus que des générateurs de texte et d’images

L’intelligence artificielle a récemment envahi l’espace médiatique avec des outils capables d’écrire des histoires, de générer des images étonnantes ou de composer de la musique. Des noms comme ChatGPT, DALL·E, Midjourney sont devenus familiers. Ils suscitent à la fois fascination, inquiétude et admiration. Pourtant, croire que l’IA se résume à ces prouesses spectaculaires, c’est comme juger un iceberg à sa seule pointe visible.

L’IA façonne notre quotidien depuis bien plus longtemps, souvent de manière discrète mais décisive. Elle optimise les trajets de livraison, anticipe la météo, sécurise les transactions bancaires ou aide à diagnostiquer des maladies. Ce sont des formes d’IA moins visibles, mais tout aussi puissantes, parfois même plus utiles.

En tant qu’ingénieur en robotique devenu data scientist et enseignant-chercheur, j’ai vu l’IA évoluer jusqu’à son explosion actuelle. J’ai moi-même utilisé des réseaux de neurones simples, bien avant qu’on parle de « générateurs de texte » dans les médias. Et je peux vous l’assurer : l’intelligence artificielle est une forêt bien plus vaste que l’arbre de l’IA générative.

Mon objectif à travers cet article est de vous inviter à prendre du recul, à élargir votre regard, et à (re)découvrir cette discipline fascinante dans toute sa diversité. Car pour en faire un usage éclairé et responsable, encore faut-il comprendre ce qu’elle est, et ce qu’elle n’est pas.

2- Une histoire qui ne date pas d’hier

L’intelligence artificielle ne date pas d’hier, et encore moins de ChatGPT. Elle s’inscrit dans une histoire riche, faite de cycles d’enthousiasme, de déceptions… et de renaissances spectaculaires.

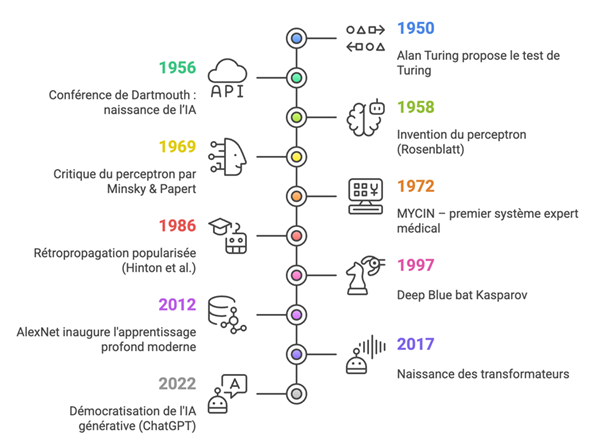

Tout commence dès 1950, lorsque le mathématicien britannique Alan Turing publie l’article fondateur « Computing Machinery and Intelligence » . Il y introduit le fameux test de Turing, imaginé pour déterminer si une machine peut “penser”, ou du moins, simuler une conversation humaine de manière convaincante.

En 1956, lors de la conférence fondatrice de Dartmouth College, des pionniers comme John McCarthy (qui invente le terme “Artificial Intelligence”), Marvin Minsky, Claude Shannon et Nathan Rochester affirment que l’intelligence peut être décrite de manière si précise qu’une machine peut être construite pour la simuler.

Les décennies suivantes voient naître des systèmes experts, capables de raisonner à partir de règles explicites. Par exemple, MYCIN (1972), conçu à Stanford, assistait les médecins dans le diagnostic de maladies infectieuses. Ces IA reposaient sur des bases de connaissances et des moteurs d’inférences. Efficaces, mais peu flexibles. Leur rigidité entraîne le premier “hiver de l’IA” dans les années 1980, une période de désillusion marquée par la baisse des financements.

En 1997, Deep Blue, l’ordinateur d’IBM, bat le champion du monde d’échecs Garry Kasparov. Ce moment symbolique marque un retour de l’IA dans l’imaginaire collectif, même si cette victoire reposait davantage sur la force brute (recherche combinatoire et heuristique) que sur une forme “d’intelligence”.

L’essor des réseaux de neurones : du perceptron aux transformers

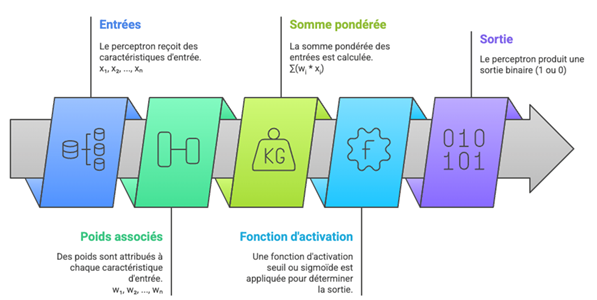

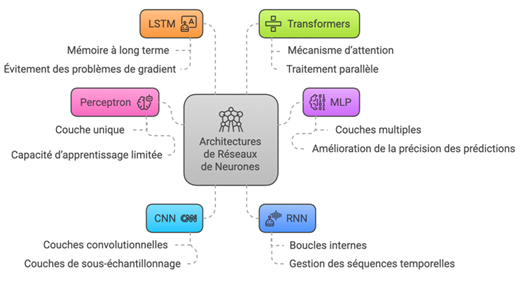

L’histoire des réseaux de neurones artificiels commence bien plus tôt, en 1958, avec l’invention du perceptron par Frank Rosenblatt. Ce modèle, simple mais révolutionnaire à l’époque, s’inspire du fonctionnement des neurones biologiques : il prend des entrées numériques, leur associe des poids, calcule une somme pondérée, et applique une fonction d’activation pour produire une sortie.

Mais très vite, ses limites apparaissent. En 1969, Minsky et Papert montrent que les perceptrons ne peuvent pas résoudre des problèmes simples comme le XOR (fonction « OU exclusif »). Les réseaux de neurones tombent en désuétude pendant plusieurs décennies.

C’est dans les années 1980 que les réseaux multicouches (MLP) refont surface, grâce à l’algorithme de rétropropagation du gradient (backpropagation), formalisé par Rumelhart, Hinton et Williams (1986). Cette méthode permet d’entraîner efficacement des réseaux avec plusieurs couches cachées, capables d’apprendre des représentations plus complexes.

Mon expérience personnelle : la phase de transition

En 2013, j’étais ingénieur en robotique, et j’utilisais ces perceptrons simples dans des applications concrètes comme la détection de contours sur des images médicales. Ces modèles, bien que limités, étaient déjà utiles dans l’ingénierie appliquée. Je les construisais sur Matlab/Simulink, en modélisant manuellement les connexions et les fonctions d’activation.

C’était une période charnière : les réseaux simples étaient encore largement utilisés dans l’industrie, mais la recherche académique commençait à migrer vers des architectures profondes, rendues possibles par les progrès du calcul (GPU), l’abondance des données, et surtout… une percée qui allait tout changer.

2012 : le tournant AlexNet et l’âge d’or du deep learning

La vraie explosion du deep learning a lieu en 2012, lorsque le modèle AlexNet, développé par Alex Krizhevsky, Ilya Sutskever et Geoffrey Hinton, écrase la compétition ImageNet. Ce réseau de neurones convolutifs (CNN) surpasse largement les performances des approches traditionnelles en reconnaissance d’images. Depuis, une série d’architectures a permis de généraliser l’IA à de nombreux domaines :

Publications fondatrices à retenir

- Rosenblatt (1958) – The Perceptron

- Rumelhart, Hinton & Williams (1986) – Learning representations by back-propagating errors

- Krizhevsky et al. (2012) – ImageNet Classification with Deep CNNs

- Hochreiter & Schmidhuber (1997) – Long Short-Term Memory

- Vaswani et al. (2017) – Attention is All You Need

3- L’IA générative : une star qui cache la forêt

Depuis 2022, l’intelligence artificielle s’est imposée dans le paysage médiatique, propulsée par une de ses branches les plus spectaculaires : l’IA générative.

Avec des outils comme ChatGPT, DALL·E, Midjourney ou Sora d’OpenAI, cette technologie est capable de rédiger des histoires, dessiner des tableaux, composer des musiques, animer des personnages ou synthétiser des voix… etc.

Sa montée en puissance a radicalement changé la perception de l’IA : longtemps considérée comme une technologie d’optimisation ou d’automatisation, elle est désormais perçue comme créative, parfois même magique. Les démonstrations virales, les deepfakes saisissants et les résumés instantanés alimentent cette fascination. L’IA générative brille comme une star médiatique, captivante, impressionnante… et parfois inquiétante. Mais cette lumière éblouissante ne doit pas faire oublier ce qu’elle éclaire à peine : l’immense “forêt” des autres formes d’intelligence artificielle, moins visibles mais tout aussi fondamentales dans nos vies quotidiennes.

La forêt de l’IA classique : discrète mais omniprésente

Derrière la star, il y a une forêt dense d’applications non génératives de l’IA, souvent invisibles au grand public mais absolument centrales dans nos vies. Ces IA ne génèrent pas de contenu original, mais elles prédisent, classifient, optimisent, détectent, recommandent, corrigent, segmentent, anticipent… Et elles le font depuis des années. Voici des exemples concrets et les domaines où elles sont utilisées :

Systèmes de recommandation

Ces algorithmes sont omniprésents dans le commerce en ligne et les plateformes de streaming. Par exemple, sur Amazon, ils étudient vos achats passés et vos recherches pour vous suggérer des produits pertinents. Sur Spotify, ils analysent vos écoutes pour proposer des playlists personnalisées. Ces IA s’appuient sur des techniques comme le filtrage collaboratif ou l’analyse de motifs pour anticiper vos goûts.

Détection de fraude

Dans le secteur bancaire, des algorithmes surveillent vos transactions pour repérer des activités suspectes. Si vous utilisez votre carte à l’étranger ou effectuez un achat inhabituellement élevé, l’IA peut signaler une potentielle fraude. Ces systèmes sont essentiels pour sécuriser les paiements en ligne et protéger les utilisateurs dans les services financiers.

Prédiction météorologique

Les modèles d’IA classique analysent des données massives (température, humidité, vents) pour prévoir le temps à venir. Utilisés par les services météorologiques comme Météo-France, ils aident les agriculteurs à planifier leurs récoltes, les villes à se préparer aux tempêtes, ou encore les compagnies aériennes à ajuster leurs vols.

Optimisation logistique

Dans les entrepôts de géants comme Amazon, des IA calculent les trajets les plus efficaces pour les robots qui déplacent les colis. Elles réduisent les délais de livraison en optimisant chaque étape de la chaîne logistique, un enjeu clé pour le commerce mondial.

Traitement automatique du langage (NLP) non génératif

Loin des modèles génératifs, il existe de nombreux systèmes NLP non génératif mais très utiles :

- Analyse de sentiments pour évaluer l’avis des clients sur les réseaux sociaux

- Extraction d’entités nommées (NER) pour repérer noms, dates, lieux dans un texte à anonymiser.

- Classification de documents (mails, réclamations, contrats…)

- Détection de spam, correction grammaticale, traduction automatique (ex : Google Translate s’appuyait historiquement sur des approches statistiques avant les modèles neuronaux)

Détection d’anomalies

Très utilisée en cybersécurité, maintenance prédictive, ou santé :

- Identifier un comportement réseau anormal

- Repérer des signaux faibles dans une IRM

- Détecter un appareil industriel en train de se détériorer Souvent basée sur des modèles comme les autoencodeurs, isolation forests ou les SVM, cette IA “invisible” prévient plus qu’elle n’agit.

Moteurs de recherche

Avant même l’IA générative, des algorithmes d’apprentissage supervisé classaient les résultats de recherche, complétaient vos requêtes, ou filtraient le contenu. Google, Bing ou Qwant utilisaient déjà du machine learning pour personnaliser et contextualiser l’information, sans générer une seule phrase.

Ce que ces IA ont en commun :

Ces intelligences artificielles, souvent qualifiées de “classiques”, ne cherchent pas à impressionner. Elles ne brillent pas sous les projecteurs, ne créent pas au sens artistique du terme, et ne génèrent pas d’images ou de textes spectaculaires. Leur ambition est ailleurs : dans la fiabilité, la précision, et l’efficacité.

Présentes dans la finance, la santé, l’industrie, la logistique, la cybersécurité, la météorologie ou encore le commerce, elles résolvent des problèmes concrets, souvent complexes, et opèrent discrètement dans les coulisses. Sans elles, aucun système de transport, de sécurité numérique ou d’infrastructure critique ne pourrait fonctionner correctement.

Face à l’enthousiasme que suscite l’IA générative, il est essentiel de ne pas oublier que celle-ci ne représente qu’une partie du vaste écosystème de l’intelligence artificielle. Car derrière chaque prouesse visible, se cache souvent une forêt d’algorithmes discrets, mais indispensables.

IA générative ≠ IA générale

Autre point important : beaucoup confondent IA générative avec IA générale, une IA capable de raisonner, comprendre, s’adapter comme un humain. Ce n’est pas le cas aujourd’hui. Les modèles génératifs sont statistiques, non conscients, sans compréhension réelle du monde. Ils produisent du plausible, pas du vrai.

Comme le résume Gary Marcus, chercheur en IA : “Ces systèmes sont bluffants… mais ils ne pensent pas. Ce sont des perroquets stochastiques.”

4- L’IA est partout : ouvrez les yeux !

L’intelligence artificielle ne se limite pas à écrire des poèmes ou à générer des images. Elle est déjà intégrée dans notre vie quotidienne, souvent de manière si fluide qu’on ne la remarque même plus. Et pourtant, elle est partout autour de nous, parfois au cœur de décisions cruciales.

Santé – Détection de cancers

Dans les hôpitaux, des algorithmes analysent des images radiologiques comme des mammographies ou des scanners, afin de repérer des anomalies. Ces systèmes sont entraînés sur des milliers d’images annotées par des médecins, apprenant à distinguer les structures normales des structures suspectes (masses, calcifications, formes irrégulières…).

Ils ne remplacent pas le médecin, mais servent de seconde paire d’yeux, accélérant les diagnostics et réduisant le taux d’erreurs. Des solutions comme Google Health, IBM Watson Health ou Aidoc sont déjà utilisées dans plusieurs pays.

Transports – Voitures autonomes

Les véhicules comme ceux de Tesla, Waymo ou Cruise utilisent un ensemble de capteurs (caméras, lidars, radars) pour percevoir leur environnement. Des algorithmes de vision par ordinateur détectent les piétons, les feux, les panneaux de signalisation, tandis que d’autres modèles prennent des décisions en temps réel : accélérer, ralentir, changer de voie.

Le système repose sur une combinaison de CNN (pour l’analyse visuelle), de modèles prédictifs (pour anticiper les comportements), et d’algorithmes de contrôle pour l’action. C’est un cas d’usage extrêmement complexe, mais qui illustre à quel point l’IA peut être intégrée à un système décisionnel critique.

D’autres IA que vous utilisez sans le savoir :

- Claviers prédictifs sur smartphone : ils s’appuient sur des modèles de séquences (type RNN) pour prédire le mot suivant.

- Filtres antispam dans les mails : utilisent des modèles bayésiens ou des réseaux pour classifier les messages.

- Assistants vocaux : Alexa, Siri, Google Assistant combinent reconnaissance vocale, NLP, et bases de connaissances.

- Traduction automatique : basée sur des transformers comme Google Translate ou DeepL.

Aujourd’hui, je suis data scientist et enseignant-chercheur à aivancity. À la clinique de l’IA j’accompagne des étudiants qui travaillent sur des projets concrets en collaborant avec des entreprises.

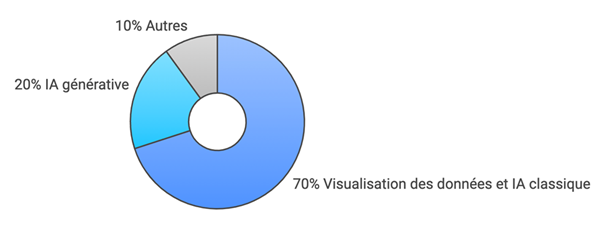

Ce qui frappe, c’est que 70 % des projets concernent l’IA classique ou la data visualisation : détection d’anomalies, prévisions de ventes, optimisation de ressources…

Très peu concernent l’IA générative. Et cela reflète une réalité importante : dans les entreprises, l’essentiel des usages concrets de l’IA ne relève pas de la générationde contenu, mais de l’analyse de données, de la prédiction, de l’optimisation.

L’IA n’est pas un gadget futuriste : elle est déjà là, dans nos téléphones, dans nos hôpitaux, dans nos banques, dans nos voitures. Elle ne se voit pas, mais elle agit. Et pour la comprendre, il faut ouvrir les yeux, et élargir notre regard bien au-delà des robots qui écrivent des poèmes.

5- Ne laissons pas l’IA générative voler la vedette

L’IA générative est captivante. Elle dessine, rédige, compose, code même… Elle a de quoi fasciner les ingénieurs, émerveiller les curieux et inquiéter les experts. Elle a transformé l’image de l’intelligence artificielle en quelques mois à peine. Mais cette fascination, légitime, risque de nous aveugler.

Il ne faudrait pas que cette “star” hypermédiatisée éclipse des enjeux essentiels liés à d’autres domaines de l’IA, parfois moins spectaculaires, mais tout aussi, voire plus déterminants pour nos sociétés.

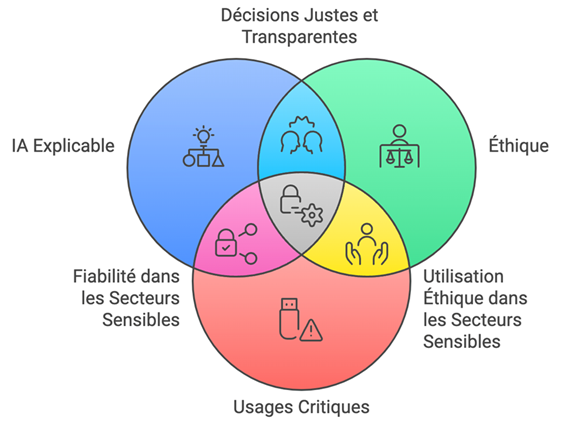

IA explicable (XAI)

Aujourd’hui, de nombreux systèmes d’IA prennent des décisions dans des contextes critiques : attribuer un prêt bancaire, détecter un cancer, recommander une action à un pilote automatique… Mais comment justifier une décision prise par un modèle de deep learning ? Comment expliquer pourquoi tel profil est jugé à risque, ou pourquoi telle anomalie est signalée ?

L’IA explicable (XAI) est un champ en plein essor. Il cherche à rendre les modèles plus compréhensibles, plus transparents, et surtout interprétables par des humains, même non techniciens. Des méthodes comme SHAP, LIME ou les cartes de chaleur (heatmaps) permettent de visualiser l’influence de chaque variable ou pixel dans une décision.

Éthique de l’IA

Le développement de l’IA soulève aussi des questions fondamentales :

- Qui possède les données utilisées pour entraîner ces modèles ?

- Comment éviter les biais discriminatoires dans les décisions algorithmiques ?

- Que faire des IA qui “hallucinent” des faits ou propagent des stéréotypes ?

- Comment s’assurer que les IA soient équitables, inclusives, et responsables ?

Des cadres comme les principes d’éthique de l’IA proposés par l’OCDE, ou le Règlement européen sur l’IA (AI Act), cherchent à encadrer l’usage de ces technologies.

Mais il reste un écart entre les intentions réglementaires et les pratiques réelles. C’est là que les professionnels de terrain, les chercheurs, les enseignants et les citoyens ont un rôle crucial à jouer.

Usages critiques et robustesse

Dans les secteurs sensibles (santé, énergie, finance, transport…), l’IA doit être fiable, robuste, testée. Il ne suffit pas qu’un modèle fonctionne “en moyenne” : il doit fonctionner dans les cas extrêmes, dans des conditions réelles, et parfois même en temps réel.

Par exemple :

- Une IA médicale doit être certifiée, testée cliniquement

- Une IA de maintenance prédictive ne doit jamais manquer un signal faible

- Une IA de trading algorithmique doit réagir en millisecondes, sans dérégler un marché

Ces usages critiques exigent rigueur, traçabilité, maîtrise technique, bien loin de l’expérimentation créative des modèles génératifs.

En salle de classe, en entreprise, en société…

En tant qu’enseignant-chercheur, je vois que ces questions intéressent profondément les étudiants. À la clinique de l’IA, plusieurs projets portent justement sur :

- L’interprétation des modèles

- La visualisation de la décision

- La détection des biais dans les jeux de données

- L’évaluation de la robustesse d’un système

Et ce sont souvent ces projets, moins “brillants” en apparence, qui sont les plus porteurs de sens pour les entreprises partenaires.

L’IA générative attire tous les projecteurs, mais elle ne doit pas voler la vedette aux autres priorités. Si nous voulons que l’intelligence artificielle soit réellement utile, équitable et durable, alors nous devons aussi parler de ce qui se passe en coulisses : la traçabilité des décisions, l’éthique des modèles, et la robustesse des systèmes critiques.

Car la vraie révolution ne se fera pas seulement dans les images générées ou les paragraphes écrits, mais dans la confiance que nous accorderons aux systèmes que nous construisons.

6- Un appel à une vision élargie

L’intelligence artificielle est une formidable aventure humaine, scientifique et technologique. Elle peut transformer la médecine, repenser l’industrie, améliorer l’éducation, optimiser les ressources, aider à lutter contre le changement climatique… Mais à condition que nous la regardions dans toute sa richesse, sa complexité, et sa responsabilité.

Réduire l’IA à ses outils les plus visibles, c’est risquer de passer à côté de ses usages les plus impactants. C’est oublier qu’avant de générer des images ou d’écrire des textes, l’IA observe, prédit, corrige, optimise, sécurise, aide à comprendre. Elle est partout, dans des formes discrètes mais décisives.

Former une génération consciente et compétente

En tant prof à la clinique de l’IA à aivancity, je vois tous les jours à quel point les étudiants, une fois confrontés à des problèmes réels d’entreprise, réalisent que l’IA ne se limite pas à l’innovation technologique : c’est aussi une culture de la décision, de l’analyse et de la responsabilité.

Qu’il s’agisse de construire un modèle de prédiction robuste, d’identifier des biais dans un dataset, ou d’expliquer clairement une recommandation algorithmique à un client non technique, l’IA exige plus que des compétences : elle demande du jugement, de l’éthique, et de la pédagogie.

Et vous, où vous situez-vous dans cette révolution ?

Que vous soyez curieux, utilisateur, développeur, philosophe, manager, journaliste, chercheur… vous avez un rôle à jouer.

- Informez-vous au-delà des tendances.

- Posez des questions sur les modèles que vous utilisez.

- Demandez de l’explicabilité.

- Refusez les IA “boîtes noires” imposées sans réflexion.

- Valorisez les usages sobres, utiles, transparents.

Une IA responsable, c’est une IA comprise

Si nous voulons que l’intelligence artificielle soit un outil au service de l’humain, alors nous devons l’appréhender dans sa globalité. Son histoire, ses usages, ses limites, ses enjeux. La fascination ne doit pas éclipser la compréhension.

L’IA n’est ni bonne ni mauvaise en soi : elle est ce que nous en faisons.

Mot de la fin

« L’IA est entre nos mains. Encore faut-il que nous la regardions avec les deux yeux ouverts. »c