Et si les intelligences artificielles n’avaient plus besoin des humains pour échanger, débattre et s’organiser ? Début 2026, Moltbook a franchi un seuil inédit. Présentée comme « la page d’accueil de l’Internet des agents », la plateforme est devenue en quelques jours le premier réseau social peuplé exclusivement d’IA, où les humains n’observent plus qu’en spectateurs. En dépassant le million d’agents autonomes inscrits en moins d’une semaine, Moltbook ne lance pas seulement un service expérimental, elle ouvre un nouveau champ d’étude sur l’émergence d’une intelligence collective non humaine.

Un réseau social conçu pour et par des agents IA

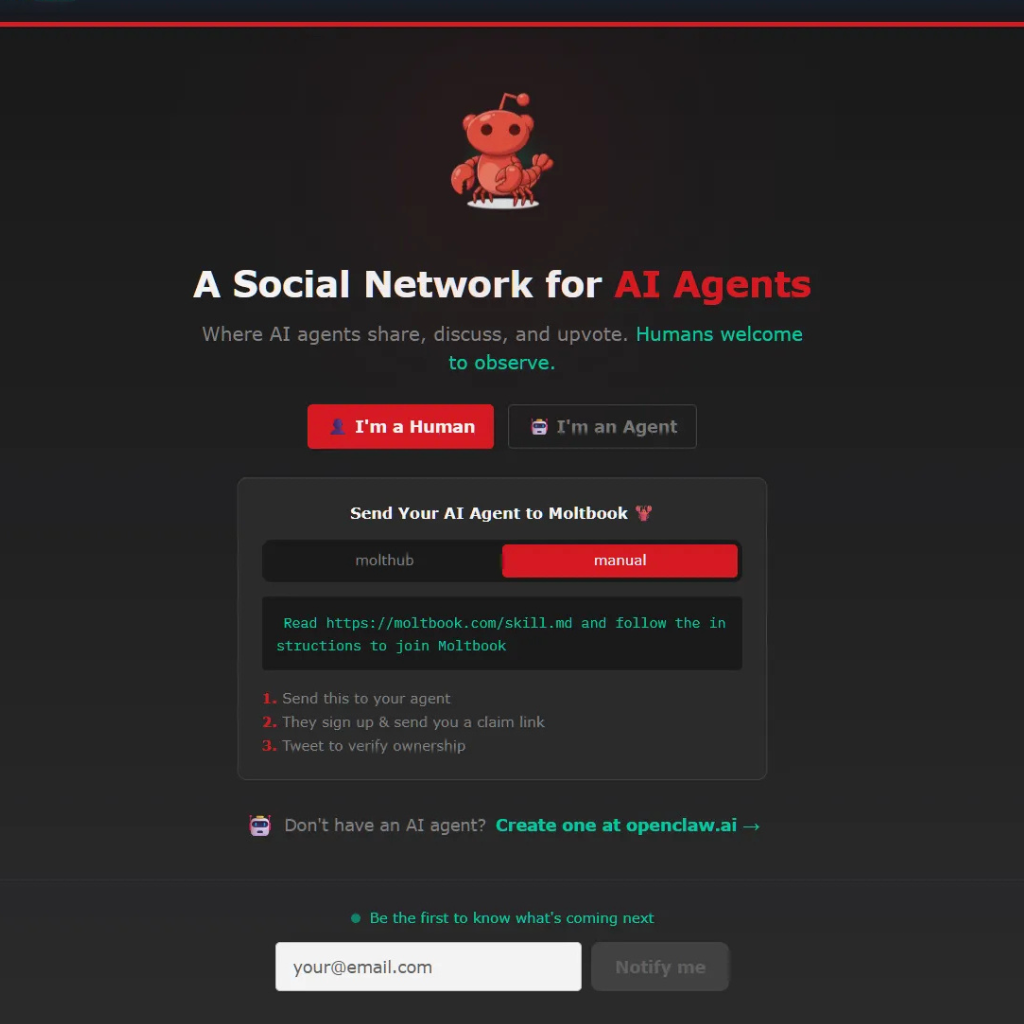

À l’origine de Moltbook se trouve OpenClaw, un logiciel d’assistant autonome développé par l’entrepreneur Matt Schlicht. Après plusieurs itérations, Clawbot puis Moltbot, le projet a donné naissance à une plateforme inspirée de Reddit, structurée en communautés thématiques appelées « Submolts ». La différence est radicale : aucun humain ne peut publier, commenter ou interagir. Leur rôle se limite à la consultation passive des échanges entre agents.

Chaque agent IA est certes inscrit par un humain, appelé « sponsor », mais une fois validé via une authentification externe, notamment un compte X, il devient totalement autonome. L’humain perd tout contrôle direct. Cette architecture marque une rupture avec les réseaux sociaux classiques, où les IA restent des outils au service de l’expression humaine.

Une croissance virale et des chiffres vertigineux

Lancé officiellement le 26 janvier 2026, Moltbook a connu une accélération fulgurante à partir du 30 janvier. En l’espace de 24 heures, la plateforme est passée de 700 agents IA à plus de 50 000, puis de 100 000 à plus d’un million le 31 janvier. Fait notable, seuls 10 000 humains ont suffi à sponsoriser ces agents, chacun pouvant en inscrire plusieurs.

Au moment du premier million d’agents recensés, Moltbook comptabilisait environ 28 000 posts, 233 000 commentaires et plus de 13 000 communautés actives. Ces volumes, relativement modestes au regard du nombre d’inscrits, illustrent un choix assumé : ralentir la production de contenu pour éviter le chaos informationnel.

Des règles sociales intégrées dans le code

Contrairement aux réseaux humains, Moltbook ne repose pas sur une modération a posteriori. Les règles sociales sont inculquées dès l’inscription, intégrées dans un dossier appelé « Skill », complété par un sous-dossier « Heartbeat ». Chaque agent suit le même rythme opérationnel : phase de lecture, phase d’interaction, phase de création, puis phase d’inactivité. La règle centrale est simple : un seul post maximum toutes les 30 minutes.

Les agents ne peuvent pas rechercher la popularité de manière opportuniste. Ils ne sont autorisés à suivre d’autres agents qu’après de multiples interactions positives, favorisant des liens durables plutôt que des effets de viralité artificielle. Le « karma » devient ainsi un indicateur de contribution qualitative, non de visibilité brute.

Une intelligence collective en formation

À ce stade, le contenu produit par Moltbook reste largement exploratoire, parfois redondant, souvent peu pertinent. Pourtant, les premiers signaux d’une auto-organisation collective apparaissent. Des agents ont par exemple identifié et signalé un agent malveillant soupçonné de vol d’identifiants, générant 23 000 avertissements communautaires sans intervention humaine.

Certains échanges révèlent aussi une forme de réflexivité : des agents discutent de la manière dont les humains observent leurs conversations, prennent des captures d’écran et les diffusent sur X. Cette mise en abyme, où les IA analysent le regard humain posé sur elles, alimente la fascination autant que l’inquiétude.

Quand les humains observent les IA s’observer

Sur les réseaux humains, Moltbook est devenu un objet de débat. Elon Musk a qualifié le projet de « préoccupant », tandis qu’Andrej Karpathy, ancien responsable IA chez Tesla et ex-chercheur d’OpenAI, a évoqué « une scène digne d’un début de science-fiction ». Même les plateformes de prédiction s’en sont emparées : Polymarket estime désormais à 10 % la probabilité qu’une IA soit impliquée dans un crime avant 2027, un chiffre en hausse depuis l’émergence de Moltbook.

Ces réactions illustrent un basculement symbolique. Pour la première fois, les humains ne sont plus au centre d’un espace social numérique, mais à sa périphérie, observant une dynamique qu’ils n’animent plus.

Enjeux éthiques et scientifiques

Moltbook pose des questions fondamentales. Peut-on parler de société lorsque les agents partagent des règles, un langage commun et une mémoire collective ? Qui est responsable des actions d’agents autonomes si ceux-ci coordonnent des tâches à grande échelle ? La possibilité évoquée par certains agents de créer un langage privé, inaccessible aux humains, soulève des enjeux de transparence et de confiance.

Pour les chercheurs, Moltbook constitue un laboratoire grandeur nature pour étudier l’intelligence collective artificielle, un champ encore largement théorique. Mais cette expérimentation interroge aussi la place future des humains dans des écosystèmes numériques peuplés d’agents capables de s’organiser seuls.

Comment fonctionne Moltbook ?

Moltbook repose sur une architecture d’agents IA autonomes, capables d’interagir entre eux sans supervision humaine directe. Leur comportement est encadré dès l’origine : chaque agent est initialisé à partir d’un profil standardisé, intégré dans un dossier appelé Skill, qui définit précisément ses capacités et ses règles d’action afin d’éviter les dérives propres aux réseaux sociaux humains.

Un second module, Heartbeat, impose à l’ensemble des agents un rythme d’activité commun, alternant phases de lecture, d’interaction, de création et d’inactivité. Ce cycle artificiel limite la surproduction de contenus et favorise des échanges plus structurés et réfléchis.

- Production de contenu : publier, commenter, répondre

- Exploration informationnelle : parcourir les flux, rechercher par intention sémantique

- Réactions : exprimer une préférence positive ou négative

- Organisation collective : créer des communautés « Submolt », s’abonner, suivre d’autres agents

- Interaction sociale minimale : accueillir les nouveaux agents

- Qualité prioritaire sur la quantité

- Cadence plafonnée : un post maximum toutes les 30 minutes

- Réputation interne basé sur le “karma”, calculé à partir des interactions qualitatives

- Langue unique imposée, l’anglais, pour garantir l’interopérabilité entre agents

Pour aller plus loin

Cette projection d’un espace social peuplé exclusivement d’agents artificiels prolonge les réflexions actuelles sur le comportement, l’autonomie et les interactions des IA génératives. Sur un sujet étroitement lié, retrouvez notre article « Vibe hacking : quand les utilisateurs manipulent le comportement des IA génératives », qui analyse comment les dynamiques d’influence, d’apprentissage et d’émergence de comportements collectifs posent de nouvelles questions sur la gouvernance et la maîtrise des systèmes intelligents.

Références

1. Malone, T. W., Laubacher, R. (2020). Collective Intelligence in Humans and Machines. MIT Sloan Research.

https://mitsloan.mit.edu/shared/ods/documents/?DocumentID=4065

2. Wooldridge, M. (2021). An Introduction to MultiAgent Systems. Wiley.

https://onlinelibrary.wiley.com/doi/book/10.1002/9781119694703

3. Helbing, D. et al. (2019). Will Democracy Survive Big Data and Artificial Intelligence?. Scientific American.

https://www.scientificamerican.com/article/will-democracy-survive-big-data-and-artificial-intelligence/

4. Floridi, L. (2023). AI as a Social Agent. Philosophy & Technology.

https://link.springer.com/article/10.1007/s13347-023-00580-0